パネルディスカッション「生命科学の未来を予想する――データベースはもう要らなくなる...ってコト?!」(後編:議論)

ChatGPTをはじめとした生成AIの成功は、データの取り扱いに関して従来困難と考えられてきた様々な課題を解決しうると期待されています。また、ロボット技術を用いたラボラトリー・オートメーションの進展は、均質で大量なデータの迅速な取得を可能にしつつあります。今後、生命科学はどのように変わってくでしょうか?

NBDCブログでは、「トーゴーの日シンポジウム2024」(2024年10月5日・品川) のパネルディスカッション「生命科学の未来を予想する――データベースはもう要らなくなる...ってコト?!」での議論内容を3編(前編:話題提供1(牛久氏/二階堂氏)・中編:話題提供2(森氏/大上氏/大田氏)・後編:議論)に分けてお届けします。

本記事は後編です。5名のパネリストに加えて招待講演者の高橋 恒一氏 (理化学研究所) も交え、研究プロセスの変化と人間の研究者の価値の不変性、AIとデータベースの関係性やその変化、教育方法や求められるスキルの変化などについて広範囲に渡って話し合われました。

本パネルディスカッションの投影スライドや動画は、下記ページにてご覧いただけます。

研究プロセスは変わるか? 将来の研究者、データベースの姿は?

高木:これで5人の先生方から話題提供いただきました。これより、午前中のご発表も踏まえつつ、ディスカッションしてまいります。すでに質問フォームへいくつかご質問いただいてますけれども、その前にパネリストと議論を深めたいと思います。なお、午前中に講演いただいた高橋先生からも発言いただけると聞いております。

高木:さて、いろんな観点から生命科学がどうなっていくか、AI、ロボットがどう貢献するかという話がありました。生命科学のどこが、どう、これから変わるのか、全部のプロセスが変わるという考えもありますけれども、「ここが1番効率化される」、「ここは人間が要らなくなる」といったこと、またこれから研究者に求められる姿はどんなものなのか、研究者は実験をしなくて良くなるのか、仮説を立てなくて良くなるのかということをお伺いしようと思います。

牛久:ムーンショット事業に取り組んでいると似たご質問をいただくことがあります。生命科学の現場の科学者の皆さんの営みというより、少し抽象化して回答させていただくと、人間の価値として2つあると思っています。

1つは「高度な抽象化能力」です。生成AIで面白い仮説が出せるようになりましたという報告がありますが、いまの生成AIが得意なことは、見たような記述を新しい記述につなぎ直すことなのですよね。どこかで見たことがあるような文脈に則って別のことは言える。その中に面白いことはあるのかもしれないのですが、新しい概念があるのか、見たこともない現象や法則、機序を出力できるかというと難しい。なぜかと言うと、例えば、そういう単語の羅列を出していった時、そこに抽象的に「別の学術分野と知識として融合できるよね」「アナロジーが効くよね」といったような知識は生成AIの中にないからです。生成AIには、それぞれ等しく単語にしか見えてない。

もう1つ人間が得意なことは、ロボットの研究者としては耳が痛いのですが、人間の方がよっぽど「安くて優秀なアクチュエーター」だということです。例えば、液体を別の容器に移すのはいくらでも自動化できているのですが、状況によってちょっと適用的に動かなきゃいけない、ちょっと工夫しなきゃいけないとなった瞬間に、ロボットにとっては非常に面倒くさくなります。頑張って再構築すると人間の方が安かったよねとなることがよくあるのですね。ちょっとした工夫、機転を利かせるような、安くて優秀なアクチュエーションとしての人間の魅力というのは残り続けると思っています。

二階堂:生命科学研究の現場で何が1番変わったかと考えていたのですが、プログラミングをだいぶしなくなりました。8割、9割ぐらいは生成AIに書いてもらって研究しています。他人が書いたコードを再現するのは大変で、論文の結果を再現できないとなっていたのですが、最近は生成AIに論文を読ませてコードも吐かせて...となりました。ここが1番変わったと思います。

また、バイオインフォマティシャンは「どういう解析したらいいか分からない」という相談をよく受けると思うのですが、多分僕らに聞くよりもAIに聞いた方が、正確に、いろいろと、根気よく、レスポンス早く教えてくれるので、僕にメールして返事待つよりはそっちの方が速い。お互いハッピーになったんじゃないかと思います。

どうしてそうなったかと言えば、言語モデルが出てきたからです。では今後、生命科学がどうなるかというと、言語ではなくゲノムデータそのものを学習し始めると思います。そうなると、AIに聞くだけで実験したかのようなデータが得られ、今まで複雑で大変だった実験をだいぶ減らすことができるので、そのうえで何をするかを考える必要が出てきます。先ほども申し上げましたが、個別のバイオインフォマティクスのツールやアルゴリズムの価値が相対的に下がっていく可能性があって、バイオインフォマティシャンは何をやるかというと、どうやってデータをトークン化させ、AIに学習させるかとか、どうやってラーニングさせるか、あるいは特定のタスクに特化するために最後のレイヤーを変えてどうファイン・チューニングするかというところを担当するようになると思います。個別の生物学的な疑問を持って研究してる人たちにとってみるとアシスト・ツールがたくさん出てくるので、すごい幸せな時代がやってくる。一方でインフォマティクスの人はハッピーじゃなくなっていくというイメージをもっています。

高木:バイオインフォマティシャンは失業するということですか。

二階堂:失業というよりも、ビッグサイエンスになったので、GPUと才能溢れるメンバーをたくさん持っているチームが勝つようになるということです。1人のバイオインフォマティクス――コンピューターが1台あって1人のそのアイデアがあればできたという時代から、ゲノムサイエンスのようなビッグサイエンスに切り替わるので、そうした大きな流れに飲み込まれるようなテーマ設定はなくなっていくということだと思います。

森:基本的には、予測できるものは実験しなくなると思います。シーケシングも空間オミクスも非常にコストがかかるので、基盤モデルができて結果が予測できるならばわざわざ実験しない方向に動いていくと思います。

一方で、微生物であれば「これまで見つかってなかった系統の微生物が見つかって新規な形質が記述できました」というのは未だによくある話です。研究者の中の1つの役割として、今まで知られてなかった生命現象や生物を記述するということは今後も重要視されると思います。「これはこういう実験をすればすぐ結果分かって、基盤モデルに入力すれば多分こういう結果になる」というルーチン・ワーク的なことは、ほとんど行われなくなるのではないでしょうか。

高木:冒頭のご発表で最後の方で論文からの情報抽出というお話がありましたが、うまくいくとアノテーターという職業はなくなりますか? それとも牛久先生が「安くて優秀なアクチュエーター」などといった人間の価値に言及されていましたが、同様に逆に重要性が増すでしょうか?

森:開発したツールで論文から情報取ってきた結果を、アノテーターが数年かけて蓄積したマニュアル・アノテーションの結果と比較すると正当率は6割から7割でした。残りの3割、4割は人間が高度に判断――「これとこれの情報が関連付けられるから、ここはこういうアノテーションつけられるんじゃないか」――していたものです。この3割、4割のうち一部は次第にパターン化され、割合が下がっていく(正答率が上がっていく)と思いますが、いまはまだそのレベルではありません。

大上:話題提供の最後のページで紹介しましたが、バイオロジーの細分化が間違いなく進むと思います。二階堂さんもおっしゃっていましたけども、より細かい現象に注力するようになっていくというのはその通りだと思います。

ただ、それでバイオインフォマティクスの立場がどう変わるかというと、大して変わらないのではないかと思っています。10年以上前にサポートベクターマシンが登場しましたが、我々がやっていたことは今も大して変わってないですよね。確かにChatGPTのような便利な道具はすごく増えてきたのですが、その便利な道具をうまく使える人もしくはその便利な道具を使って応用方法を思いつける人と、そういった便利道具をコンピュータービジョンやNLPなどの分野から輸入してきてアレンジして作る人という2つにより分れていくのではないでしょうか。それは、ゲノム解析において「ツールを使いこなせる人」と「ツールを作れる人」とに2分化されていたところと似てるかと思います。いろんな計算にGPUが必要になっていくのですが、GPUって1枚で人間の年収ぐらいあるのですよね。なので、そう簡単にバンバン買えるものではない。ビッグテックがいろんな基盤モデルを作る構図は今後も加速するので、そうしたときに我々に一体何ができるかというのは深刻な問題だと思います。

大田:生成AIで何が変わったかというのを考えていましたが、ひとつは、二階堂先生と同じで、プログラミングがもうCopilotに任せっきり。もう本当書かなくなってしまって悲しい限りです。もう1つは、文章を書くところ・読むところです。論文のドラフトも、箇条書きを入力すれば全部ドンと作ってもらえるわけですし、読むのもそう。そうすると、論文を書いて、公開して、査読を受けて、出版するというフローがなくなって、論文出版社がすべて潰れるのではないでしょうか。公開しておけば読めるわけですから。論文内の主張の正当性もマシンが判断してくれるのであれば、別に査読いらないですよね、ジャーナルもいらないんじゃないですかとなるように、個人的には思っています。そうやって文章に関わる時間が減った代わりに何をするかというと、マシンの中に入ってない新しいデータを作るところに価値があると思うので、二階堂先生がやられてるような新しい計測技術の開発であったり今まで誰も行ったことがない場所にあるサンプルの採取であったりとか、そういった希少価値の高いデータを作る・見つける・取ってくるところが、近い10年ではメインになるかなと思っています。

高木:お話を聞いていると、すごく効率化される部分がある一方で、研究の本質的なプロセスは変わらないように受け取りました。高橋先生、研究がどう変わっていくのか、研究者の仕事はどう変わってくのかについてご意見ございますでしょうか。

高橋:冒頭で高木先生から「人間の研究者がいらなくなるのか」、「データベースいらなくなるのか」という話がありましたが、この2つは同じ構造だと考えていました。

どういうことかと言うと、人類の歴史は何万年も続いているわけですが、新しい技術が出るたび、今まで手作業でやってたことを道具や機械に任せて、その道具や機械を使いこなすところにスキルセットが移行してきました。生成AIが出てきたことで、今まで手でやっていた作業が一部自動化されるけれども、例えば、研究の計画を立てるとか、何を研究するか決めるのは価値判断で、人間しかできないわけで、最終的に残っていくと思います。

哲学的な話をすると、科学とは、非常に複雑な世界の仕組みを僕らの限られた容量の人間の脳の構造、人間の認知能力で理解できる形で記述することです。何が分かりやすくて何が分かりやすくないかということは人間にしか判断できないわけです。ですから、人間の役割はなくならない。

これは「データベースが必要か」という問いへの答えと同じだと思っています。今までは遺伝子の機能や分子の種類などのデータベースを作ってきたわけですが、それをベースにもう1つ上のレベルで蓄積するべきデータがどんどん出てくるからです。具体的には、午前中にお話したように、実験のデータベース――どんな実験をしてどんな結果出てきたといったものです。今まで手作業だとなかなかメタデータも残らないし再現性もないので、データベース化が難しかったわけですが、それらがデータベース化できるようになっていく。また、仮説や研究計画などの上のレイヤーのデータが出てきて、これらのデータは下のレイヤーの、分子の機能といったデータベースを基礎として成り立つ。このように、積み上がっていくだけだと思うのです。

その際に大事になるのはアノテーションやメタデータの整理で、研究を自動化できるかはそれにかかっていると思っています。実験ロボットがあるから実験のデータベース化ができるというのは、実験ロボットがAIで制御されているのでメタデータをその場で正確に生成できるからです。それができる領域はどんどん自動化が進んでいくでしょう。これまでも実験データのデータベース化というのはいろいろな取り組まれているのですが、なかなかできてない。それは、人間の研究者にメタデータをちゃんとデータを整形して生データを提供し、それを人が処理してメタデータを付与してデータベースに取り込むUI/UXがなかなか効率化されなかったので難しかったということだと思います。この辺りが非常に本質的な議論で、今日いらっしゃってる方のうち何名かはその辺りをご専門されているので、ご意見を伺ってみたいと思いました。

高木:どうもありがとうございました。

生成AIによって変わる学習スタイルと求められるスキル

高木:ここで、参加者からのご質問をお受けしたいと思います。質問フォームへもいくつか質問をいただいていますけども、大部分はこれまでのご発言でお答えされたことだと思いますので、現地会場にいらっしゃる方からご質問・ご意見をいただけたらと思います。

フロア:二階堂先生から「プログラミングをする時間が減った」というお話がありました。プログラミングができる方であればご利益を得られる一方で、初学者はおそらくバグが入ったコードが出力されても気づかないまま使ってしまうことがあると思います。今回登壇されているような方々は生成AIのメリットを享受できると思うのですが、まったく初学者の方は、生成AIとどういう風に付き合えばいいと思われますか。

二階堂:もっともな意見だと思います。便利なツールによって全ての人が幸せになるわけではなく、格差が広がることが往々にしてあって、生成AIも同様だろうと思います。プログラミングそのものを知らなければ、生成AIが出力した結果を理解・判断できず、どう聞いたらいいかも分からないわけです。

プログラミングは、ステレオタイプですが、「コミュニケーションは苦手だけど、コンピューターに向かって独学できるタイプ」が得意な印象を持ちます。しかし、生成AIの利用にはコミュニケーションが求められ、コミュニケーションが得意な人の方が学習速度が早くなる可能性があると思っています。AIがどう考えるか、どうレスポンスするかを想像して問い合わせをする、これは人とコミュニケーションするときに必要なスキルと同じです。学生を指導していても、聞く力が強い人、疑問を持つ力の強い人の方が生成AIを使いこなしているようにみえます。そのような人は、最初、プログラミングが下手であっても、生成AIと「こういうバグが出たのだが」等とうまく相談しています。

わざと、シングルセルRNA-seq解析の間違えがちなポイントを避けられるか試したことがあるのですが、ちゃんと聞けばきちんと解決策を示してくれるのですよね。人に教わる場合、暗黙知化しているために、ある処理を行なう理由などの背景を教えてくれないことがありますが、AIは聞けば答えてくれます。疑問を持つことのできる人にとっては大きな恩恵となるはずです。初期のスキル・レベルよりもコミュニケーション・レベルによって成長速度が早まるケースがありえると思っています。

フロア:ありがとうございました。新しいタイプの教育が必要になるのかもしれないですね。

高木:大上先生はいかがでしょうか。

大上:プログラミングをはじめて学ぶ学生の教育に関わっていますが、教員の側に立つとプログラミング教育をしづらくなった印象があります。生成AIに聞けば答えが出てきてしまうからです。「プログラミングを習得した」という自認をどう得るか、難しい時代になったと思うのです。「生成AIに聞いて出てきたコードを理解したつもりになっているものの、実際は理解できていない」という状況に陥りやすくなったのではないでしょうか。こうした意味では、教育方法を再考する必要があると思っています。

ただ、便利な道具であることは間違いありません。二階堂先生がおっしゃったように、生成AIに「これ、ちょっと結果が変なのだけど」と指摘すれば、コードを直してくれるので、使いこなせる人にとっては物事が早く進むようになったと思います。

高橋:一言よろしいでしょうか。教育は非常に重要だと思っております。我々は未来事業において、尾崎先生を中心にしてロボット実験の授業を実施しています。こだわったのは、学部1年生から受講できること、また実習でやること。ピペットをにぎった経験もないような学生を対象にしてロボット・ネイティブを育てたかったからです。

ここで得られた知見は、人間とロボットとの身体性の違いでした。人間は「こうすれば速くなる」といった工夫ができますが、間違えることがあります。一方、ロボットは同じ操作を正確に速く行えますがトラブルが生じても修正できません。これはロボットにセンサーが不足しているためです。AIが得意なこと、人間が得意なことを組み合わせることで生産的な関係を結ぶことができるのではないかと思います。人間とAI、人間とロボットの身体性の違いを認識することによって、次世代のロボット・ネイティブが生まれ、サイエンスを変えていってくれるものと思います。

高木:ありがとうございました。

無作為かつ大規模なデータ取得と人間からのフィードバックが重要

高木:質問フォームへの投稿に、二階堂先生と牛久先生に答えていただきたいと思います。「AIが見たことがないデータを持つことの重要性には深く同意します。具体的にはどのようなデータを念頭に置いているかご教示ください」。いかがでしょうか。

二階堂:ここ数年、私が研究で重視している点に関わるご質問だと思いました。遺伝子研究の偏りをジニ係数を使って定量すると、人類は APOE、CD4、BRCA1/2といった遺伝子ばかり研究していることが分かります。AIはインターネット上の情報から学習するわけですが、AIはこうした一部の遺伝のデータしか知らないわけです。また、失敗データ (「薬剤を投与したが効果がなかった」等) についてもインターネット上にはありません。AIは、そしておそらく人類も同じですが、そうした偏ったデータを元に判断をしていることになります。

したがって、今後は、無作為な実験が非常に重要になってくると考えています。ゲノム科学は無作為にデータを取得することが得意な領域で、ヒトゲノムの全体配列の決定もcDNAの配列決定も、当初、その意義が十分理解されていたわけではありませんが、現代の生命科学に大きな影響を及ぼしています。同様に、いろいろな個体、細胞をさまざまな条件にさらしたときのオミクスデータを大量に取得していくべきだと考えます。例えば、膜透過性の低い薬剤を細胞投与してRNA-seqするような実験データがあればA細細胞膜を透過しないことをAIが学ぶことができますが、普通、人間はやらないですよね。であれば、ロボットやスクリーニングなどで大量にデータを取得するしかない。AIも人間も見たことがないようなデータというのは、そうした無作為な実験によってしか取得し得ないと思っています。また、期待される条件を能動的に選んでロボットに実験させようとするとなるとデータの偏りがますます進んでしまいます。ロボットに能動的に実験させるためにも、無作為なデータが必要になります。いろいろな摂動における全遺伝子規模の計測をこれまでの100倍、1000倍も取得しなければ、基盤モデルを開発できません。さまざまな摂動の種類、モダリティ、細胞の種類、材料、人種、計測技術でデータを取得することが重要です。データが湧き出してくる「データ油田」を押さえることが、AI、基盤モデルの時代に非常に重要で、研究の源の全てにすらなる可能性があると思っています。

高木:無作為にと言っても、探索空間が広すぎないでしょうか。何らかの方向性や絞り込みが必要になりませんか。

二階堂:計測手法や予算に制約があることを踏まえると、例えば、化合物構造をクラスタリングして、効率的なライブラリのなかで条件を振るといった工夫は、実務上は必要になると思います。

牛久:自律的に実験しながら無作為にデータを取得していくことが重要との意見に同意します。加えて申し上げたいのは「人間とのインタラクション」です。

例えば、研究室で指導教官に実験アイデアを相談するなかで学生は「これはやっちゃいけない」といった、論文に記載のないようなルール・法則を学び取っていきます。そうしたルール・法則を人間がAIに対してフィードバックし、AIロボットサイエンティストの"見習い"が学習することが、今後、未知の領域を探索していく際の土台となると思っています。これはロボットでも同様です。現状、ロボットよりも人間の方が効率的な動作を学習しやすいわけですが、その人間が得る視覚的、力学的な多様なフィードバックを得ながらロボット自身が学習できる技術が必要になると思っています。

また、「こういう複雑で長いプロンプトを打つと良い」といった解説を見聞きすることがありますが、長々しいプロンプトを入力するのは面倒くさいですよね。とすると、今後、生成AIを利用するための"プロンプト・ジェネレーター"――プロンプト短く入力するだけで、入力者の意図通りに出力されるよう補完する仕組みが出現すると思っています。こうした仕組みを実装するためにもやはり「人間とのインタラクション」が重要になってくるはずです。

高木:ありがとうございました。

AI、ロボット技術の発展におけるボトルネックとは

高木:もう1点議論したうえで、後半の議論に移りたいと思います。フォームに投稿いただいた質問で「シンギュラリティについてどう考えますか」という難しい質問につき、パネリストの皆さまからご意見あれば伺いたいと思います。また、生命科学をロボット、AIで変えていく時に何が一番のボトルネックになるとお考えでしょうか? さきほど、大田先生から、基礎生物学研究であれば問題なくとも、医療に関しては倫理面などの問題があるという話がありましたので、まず大田先生に、シンギュラリティ、あるいはボトルネックについて、医療現場で使えるのかなどお伺いしたいと思います。

大田:ボトルネックについてお答えしたいと思います。冒頭の話題提供で色々なボトルネックがあるとお話しましたが、1番は「資金」だと思います。AIの有無とは別に、研究をするモチベーションの1つが社会的な需要だということを、皆さん、COVID-19で感じられたと思います。社会的需要のあるところに資金が投入され、薬を作る・機序を解明するといった研究がなされるわけです。これから超高齢化社会、少子化、抗生剤の効かないスーパー耐性菌、これからも来るであろう新たな感染症といった社会課題を解決する需要が生まれ、資金が投資され、研究所で研究がなされるという流れは度々訪れると思っています。資金を持っている国や企業が「これをやるべき」と主張する領域が1番に取り組まれることとなるので、資金のない国・企業にとって資金がボトルネックになると思っています。

高木:資金に関連し、公共データベースが充実すれば資金の少ない研究室でも研究が進められるというスキームも考えられるかと思いますが、どうお考えでしょうか。

大田:AIによって公共データベースの収録データが充実すると同時に、そうしたデータを利用したインフォマティクス研究のスピードが上がるので、先にやりきられてしまうと思うのです。公共データの増加スピードが、AIによって加速した研究のスピードを上回らないと、データベースがあるから予算を抑えて研究できるよねとはならないと思うんですよね。したがって、もうやることなくなっちゃったね、新しいデータを誰か出すのを待ってなきゃいけないとなってしまうのではないかと思います。

高木:ありがとうございました。大上先生はいかがでしょうか。

大上:いわゆる強いAIの話は専門ではないのであまり答えられないんですが、AIベースの道具に対し、バイオロジーの研究者の皆さんは、普通に使えるレベルだと感じていると思います。AlphaFoldの話ですが、論文のMethodに「AlphaFold2を使って立体構造予測して構造上のメカニズムを議論しました」と書いてもリジェクトされないと思うので、その意味ではもう信頼されていると思うのですよね。AI、いわゆる機械学習だから予測精度が心配ということもあるとは思うものの、いろんなところで人間が信頼して使って、日常的に議論に組み込んでいる状況になっているので、もう少し発展していった先にシンギュラリティへたどり着くのではないかと感じます。

高木:森先生、コメントございますか。

森:AGIが開発されないと思っている人は、今やだいぶ少ないのではないでしょうか。いずれ達成されるものと思います。一方、シンギュラリティについては、「今後の展開を見守りましょう」というところで、誰も予測できていないのではないかと思います。

高木:ボトルネックに関し、先ほどのアノテーションもいずれ人間が不要になるでしょうか。それとも、乗り越えられない壁などの感触はありますか。

森:アノテーションが必要なのは、そもそも研究者がきちんと記述してくれなかったことが原因ですよね。綺麗になっていれば本来はアノテーションする必要はないのです。データを綺麗にして過去の負債を清算し、もっと別の研究に取り組んでいくべきだと思います。

高木:二階堂先生、いかがでしょうか。

二階堂:非常に賢いAIが出現したときに人間が研究を続けていけるかという点に限定して考えてみると、例えば、研究室に非常に優秀なメンバーがAIとして1人入ってきたととしても、なにも変わらないはずです。このように、「よい仲間ができたね」というだけというのが、最も楽観的な影響が最小のケースです。

影響がもっと大きいケースを考えると、非常に賢いAI同士でサイエンスをし始めるような場合。しかし、これも、いま、海外のすごいチームがIFの高い雑誌に論文を掲載して「すごい」と眺めるのと違わないとも思います。いまでも、「自分とは異なる研究分野で興味深い研究が進められているな」と、スポーツ観戦と同様の姿勢を向けている研究分野が各々あるのではないでしょうか。

あるいは、今後、サイエンス全体がそうなっていくのかもしれません。我々は今、自然を観察して研究に取り組んでいますが、AIを観察対象としてAIの発見が人類にとって価値があるかを研究するようなサイエンスに変わっていくのかもしれません。もしそうなると、我々研究者の価値が問われ、研究者に投資する必要はないと考える人々も増えるかと思います。その場合、AIがサイエンスを進めることで身軽になるならば、もっと社会課題の解決に取り組んでいかなくては研究者の価値が薄まっていくのではないかと思っています。

一方、そうした賢いAIが賢くなった理由は、いろいろなデータを見たからですよね。AIが問題を解決したり提案したりする際に参照した最も重要なデータがもし今後定量的に分かるようになるなら、そうしたデータを産出した人がもっとも偉いわけで、そうしたデータ産出者にAI開発者が資金を投資しよう、代わりにデータを学習に利用させてくれとなるはずです。すると、もはや論文の量や質は関係がなくなり、データの産出者や、それらのデータを正しくデータベース化した人の価値が高まることとなります。そうした意味でデータベースの重要性が増していく可能性はあるかと思います。

高木:ロボットがデータを産出した場合、ロボットにそうした指示を出した人が偉いとなるのでしょうか。

二階堂:そうです。人間が、電気代や試薬代を負担しているでしょうから。

高木:牛久先生、お願いします。

牛久:時間も限られているので端的に申し上げると、「科学研究のための」といったAGIの議論は意味がある一方で、そうした前提を持たないAGIやシンギュラリティの議論は無意味だと思っています。

高木:ありがとうございました。

シンギュラリティに関し、高橋先生から質問フォームへ以下の通り投稿いただきました。

高橋:シンギュラリティについて、私一応人工知能学会の汎用人工知能研究会の専門委員でして、こちらの論文で詳しく検討していますのでご興味あれば参照ください。

生命科学にはこれからもデータベースは必要なのか

高木:それでは、後半のデータベースの話題に入ります。データベースの重要性について、また今後どういうデータベースが必要になるのか、これまでとは違うのか、量の問題なのか質の問題なのか、あるいは知識ベースが必要なのか。そうしたデータベースの利用者はAIか研究者かロボットか。データべ―スを誰がどのように作っていくのかなどについてコメントをいただければと思います。牛久先生からお願いします。

牛久:質問フォームに「AIとデータベース、どちらの使いこなし能力が今後必要になるのでしょうか」という投稿がありました。私がデータベースの研究者ではないことを前提にお聞きいただきたいのですが、「なぜデータベースかAIのどっちかだけ、となるのか」と疑問を覚えます。どちらかだけを不可分に選択することはできなくなっていくものと思っています。データベース自体の概念も変わっていくし、データベースがないAIというのもありえないわけですよね。第3次AIブーム以降のAIを使いこなす中ではデータベースも使う、データベースを使っていく中ではAIも使うということになります。おそらく今までのような決まり切ったデータベース設計というハードルが緩和されていき、例えば、データレイクのように、いろんなデータがとりあえず雑多に入っているだけでもLLMに知識を入れていくことができるし、そこからRAGベースで根拠を伴った回答を行うこともできるわけです。AIとデータベースはおそらくどんどん融和して形を変えていくのではないかと思っています。

高木:データレイクだけで十分ということでもないですよね。

牛久:難しいですね、目的によると思います。

高木:分かりました。つづいて、二階堂先生お願いします。

二階堂:繰り返しになりますが、基盤モデル・AIの時代においてデータの価値はどんどん上がっていくし、データをストレージするデータベースの価値も上がっていくと思います。LLMに限って言うと、LLMのサービスは海外のものですし、GPUも海外のもの。サイエンスの基盤モデルが出てきた時に、サービスも、計測技術も、試薬も海外製でとなると、では日本は何をやるのかという話になると思うのですよね。ただ、日本にはDDBJ、DBCLS、またPDBのアジア拠点としてデータベースを開発・提供してきた実績があるわけです。また、その隣にDDBJスパコンがあって巨大な計算が可能です。残念ながらGPU性能は足りておらず、国としてサポートしていくべきだと個人的には思っていますが。そうした背景のもと、AI readyな形へデータを変換し、利用できるようにしていくとか、基盤モデルの出力のリファレンスとしてデータベースが活躍するようにするといったところに生き残る部分があると思っています。どちらかといえばデータベースは必要だ、という立場です。

高木:つづいて森先生、お願いします。

森:私はデータベースを開発している人間ですので、データベースは今後すごく重要になっていくと思っています。ただ、今我々が接している・開発しているデータベースとは違ったものになっていくだろうと思っています。

インターフェイスにしても、多くのデータベースがキーワード検索を可能にしていると思うのですが、データベース開発者の多くはキーワード検索が最良のインターフェイスだと思ってないと思います。入力キーワードには情報が欠落しているので、例えば、遺伝子IDを入力されても、入力者が遺伝子について何が知りたいかについては、絞り込み検索をさせるなどプラスの情報がない限りは特定できません。キーワード検索しなければいけなかったのは、昔の、データベースの構造だったりクエリ言語の問題だったわけですが、それがLLMだったり生成AIによって緩和され、文章やロジックとして入力できるようになってきています。人間によるデータベースの検索の仕方も大きく変わり、当然AIエージェントによる検索はもっと異なるでしょう。ですので、1次レポジトリも2次データベースも、データの置き方やデータベースとしてどういう形で構築して公開していけば使われるデータベースになるのかというのもだいぶ変わってくだろうと考えています。

高木:ありがとうございます。大上先生、お願いします。

大上:データベースは生命科学研究で必須になっていると思いますが、研究を進めるという場面においては、データベースがもっとレコメンドしてくれるといいのにと感じます。先ほどのAIによる探索の話とも似ていますが、例えば、「こういう領域のデータが全然ないので、この辺の領域のデータを取ると論文が書きやすいですよ」などといった提案は今の技術でも実装できると思うので、そのような道具としての利便性の向上に期待しています。おそらく、そうしたデータベースが統合データベースなのだと思いますが。

もう1つは、今申し上げたことを実現するためにも、色々なデータを取り込めるようにする必要があるという意味で、「AIに優しいデータベース」という方向性があると思います。例えば、能動学習と呼ばれる、次どういうデータを取ってきたらモデルがより強化されるかというところを理論立てて考える技術が組み込まれ、「次こういうデータを取ると全体の性能が上がりますよ」という方向に進んでいくのではないかと思っています。こちらは、ロボティクスとの相性が良いのではないでしょうか。

高木:大田先生は統合データベースの開発に携わってこられましたが、コメントございますか。

大田:厳しい振りですね。牛久先生がおっしゃっていたAIとデータベースは不可分だろうというご意見に深く同意します。たくさんデータがあって何らかの形で格納し、人間――いや、人間じゃなくてもいいんですが――クライアントが問い合わせをして出力するという構造を考えると、AIもデータベースなんですよね。データがリレーショナルなテーブルに入っているのかグラフに入ってるのか、ベクトルの畳み込みで全部モデルになっているかの違いでしかなく、クエリの代わりにプロンプトを入れて出力を得るという意味ではAIもデータベースだと言え、分ける意味はないと思います。

おそらく過去のトーゴーの日シンポジウムでの講演だったと思うですが、高木先生が「生命科学の究極の目的はデータベース作りである」とおっしゃったことに非常に感銘を受けたことを覚えています。今まさに、そうなっているんですよね。みんなデータを産出して、AIを作って、AIから新しい知識を引き出すといったことをしている、結局同じトラックに乗っていると思っていて、データベースがいらなくなるかと言われると、いや、データベースがAIと呼ばれるようになったのではないかと思っています。

高木:まとめていただいてありがとうございます。

高木:もうだいぶ時間が経ちましたが、フロアにいらっしゃる方のなかにも「一言言いたい」という方がいらっしゃるのではないかと思います。どなたかいかがでしょうか。

フロア:コメントなのですが、よろしいでしょうか。パネリストの皆さんのお話にも出てきましたが、AIやデータベース、バイオインフォマティクスなど生命科学にいろいろな分野があるものの、今まで当たり前だと思われていた、分野や役割分担がどんどん融けていく、再定義されていくのだろうと思います。

例えば、ツールを作るバイオインフォマティシャンは「自分はここまでやるけど、ここに綺麗なデータを入れるのはユーザーの仕事です」といってしまう。また、実験自動化のロボット開発においても、ロボット開発者が「実験ロボットのここにプレートを置くのは人間の仕事です」という。開発にはいろいろなコストを考慮する必要があり、スコープの定義から始めることにはなるのですが、LLMなどいろいろなAIが出てきたことで、スコープを確定しなくても、どっちかがどっちかに合わせるということがしやすくなっていると思います。ですので、今まで「データベースだと思っていた」とか逆にデータベース開発者にしても「データベースを作るというのはここまでをやることだ」と思っていたことがもっと拡大してくるのが当たり前になっていくと思っています。

また、科学の分脈で言うと、今まで、コストを鑑みて「自分の研究のスコープはここまでだ」と考えていたところが、LLMという何を聞いても怒られない別分野の専門家のような存在が隣にいると、学際研究や分野横断研究、階層横断研究がしやすくなるのではないかと期待しています。

高木:ありがとうございました。もう1人お受けしたいと思いますが、いかがでしょうか。

フロア:今日お話を伺ってあらためて感じたのは、サイエンスに関するデータのアクセシビリティが上がり、LLMに聞けばたくさんの論文の概要を教えてくれるようになったことで、私たちが本当に知りたいことは何か?ということに時間が使える時代が来たということです。

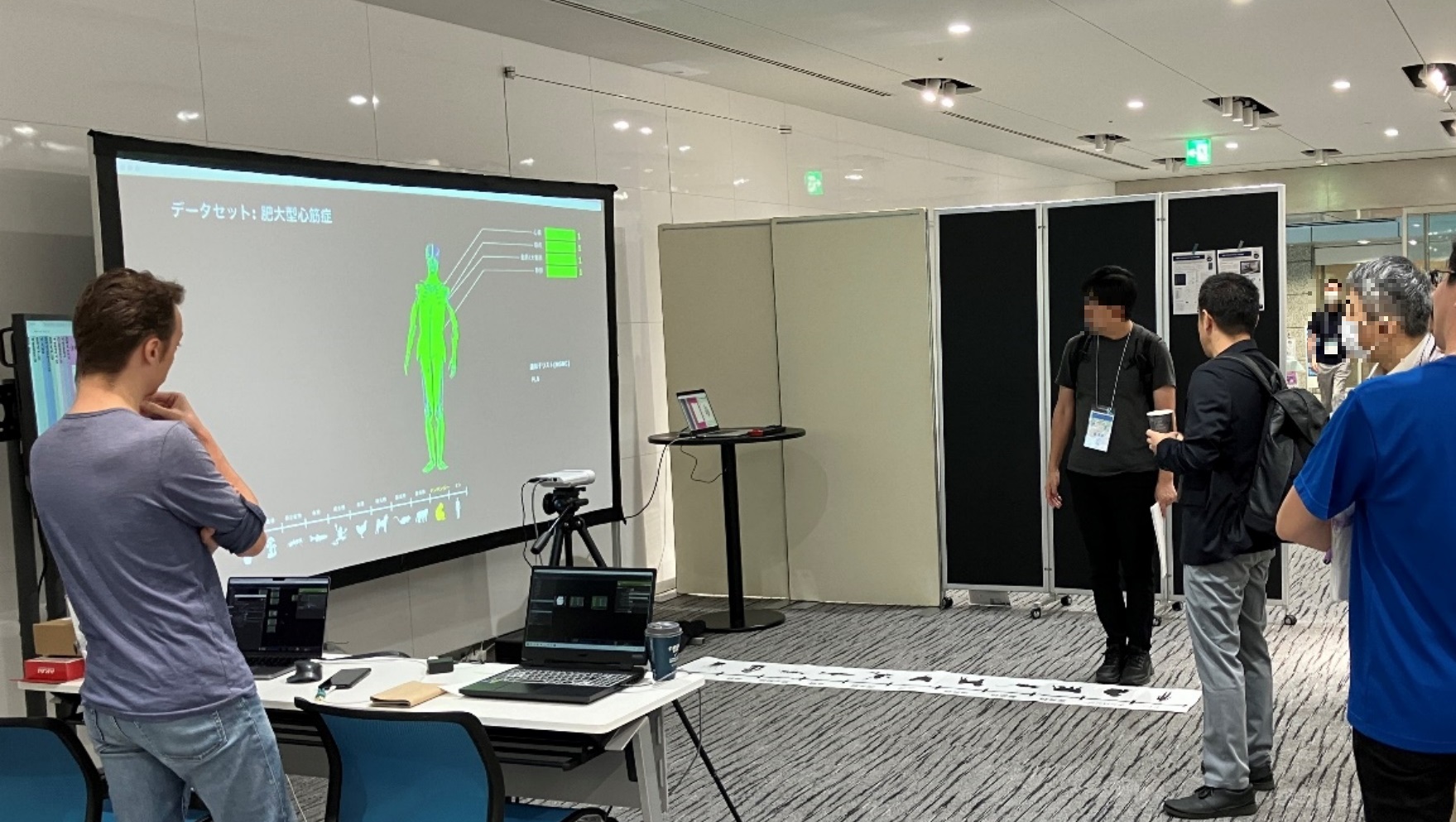

本日、人体が動くブース展示をおこなっています。この展示では、ゲノムの情報、ヒトの遺伝子、タンパク質の立体構造、バリアントなどいろいろなデータベースにあるものを全部まとめ、表示しています。説明文はLLMに作らせました。まだご覧になっていない方もいらっしゃると思うのですが、ぜひ体験いただいて、「こういう病気の原因を知りたい」と投げかけた時に、何がまだデータベースやLLMで答えられないのかについて、また、ロボットによる実験から、次何に取り組むべきかまで、一緒にディスカッションできればと思います。

DBCLSは、本シンポジウムで「Data Integration Visual Exploration (DIVE)」プロジェクトに関する展示物について実演をおこなった。DIVEプロジェクトは、膨大なグラフ・データのインタラクティブな可視化を模索するもの。本展示では、ヒトの遺伝子セットの各臓器での発現量および当該遺伝子の進化的な関係を表示させた。遺伝子セットはユーザーが任意に選択可能。また、進化的な関係は、ユーザーが左右に移動することで表示を変更できる。人体モデルにはDBCLSが開発・提供するBodyParts3Dを用いられている。

各遺伝子は、DIVEプロジェクトのウェブサイトへアクセスすると詳細情報を閲覧できる。発現情報はRefEx、GTEx、ProteinAtlasデータベースから、タンパク質としての機能はUniProtデータベースから、立体構造はPDBデータベースから、バリアントの情報と臨床的意義はTogoVarおよびClinVarデータベースから、リファレンスの情報はTogoGenomeを経由してPubMedデータベースから取得された。また、LLMを用いて遺伝子情報を要約、和訳している。これら多岐にわたるデータの一元利用は、DBCLSが研究データのRDF化を通じて整備・統合を推進してきたことによって実現している。また、データの可視化には、DBCLSが開発・提供してきたRDFデータの可視化フレームワークTogoStanza、MetaStanzaが用いている。

高木:ありがとうございます。次の方で最後にしたいと思います。

フロア:私はまだ学生です。今日のお話にあったように、AIが出てきたとしてもプログラミング自体をその自分が知っていなければうまく使いこなせないですし、ロボットが実験してくれるとしてもその実験を自分が行ったことがなければロボットがどこで失敗してるのかが分からないかと思います。今後、学生は、何を中心に学ぶべきでしょうか。AIの使い方にリソースを割いた方がいいのか、それとも実験やAIの仕組みといった基礎に時間を割いた方がよいでしょうか。

大上:基礎の勉強はした方がよいです。例えば、電卓の中身を知らなくとも電卓は使えるものの、中身を知っておいてほうが安心できるから、また、別の便利な道具を自分で作りたいと思ったときに何をすべきかが分かるからです。統計的機械学習などは勉強しておいて損はないと思います。ただ、昔の教科書の内容が古いといったことはよくあると思います。勉強の仕方は時代とともに少しずつ変わっていますし、プログラミングもおそらく同様です。いまある便利な道具を使うことで効率的に学習していけるかと思います。

高木:質問フォームにもいくつか投稿いただいているのですが、時間が超過していますので、申し訳ないのですが、ここで終了したいと思います。

高木:パネリストの皆さん、本日はどうもありがとうございました。最初に申し上げましたように議論をまとめることはしません。皆さんそれぞれ感じ取っていただければという風に思います。

私としてはもう少し過激なこともあるかなと思ったのですが、皆さんサイエンティストとして非常に真面目にお答えになられたので、思ったほど過激にならなくて良かったような反省のような気持ちでございます。これにてパネルディスカッションを終了したいと思います。ありがとうございました。