Biomedical Linked Annotation Hackathon 6(BLAH6)参加報告

NBDC研究員の建石です。

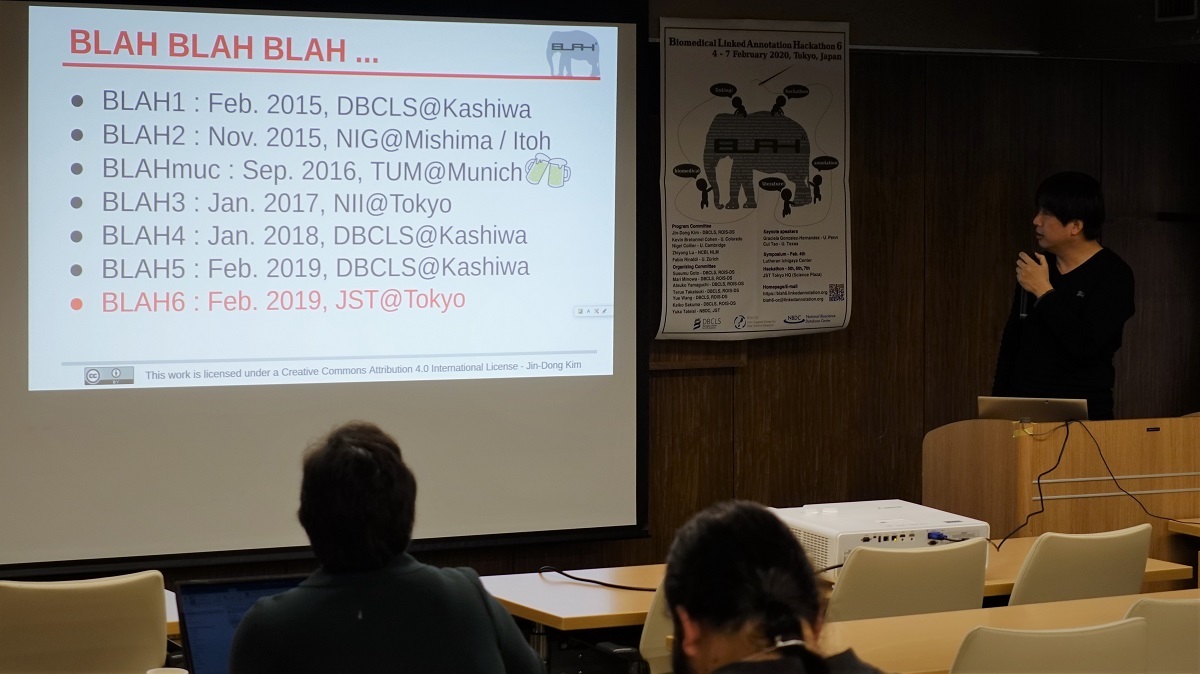

2020年2月4日から7日にJST東京本部で第6回 Biomedical Linked Annotation Hackathon 6(BLAH6)がDBCLSとNBDCの共催で行われ、私もオーガナイザーのひとり、また、開発者のひとりとして参加してきました。

そもそもBLAHとは

BLAHはBioHackathonの自然言語処理版ともいえるもので、医学・生物学関係のテキストマイニング、とくに、テキストマイニングのために必要なアノテーションの作成や解析に関連する仕事をしている研究開発者が一堂に会して技術開発や情報交換を行う場(ハッカソン)です。

人間同士のコミュニケーションで様々な形のテキストが大きな役割を果たしていることは医学・生物学分野も例外ではありません。最新の研究成果は学術論文の形で発表されますし、研究以外でも、プレスリリース、公的機関の情報サイトなど一般の方々向けの情報もたくさんあります。最近では文献やWebサイトの増加スピードが速く、検索やフィルタリングの自動化がすすめられています。しかし、自然言語のテキストはデータベースのように構造化されていないため、機械的にテキストの内容にアクセスするのは簡単ではありません。

テキストから必要な情報を抽出することをテキストマイニング、テキストのどの部分に必要な情報が書かれているかを機械的にわかるように示していくことをアノテーションといい、テキストのアノテーションは、テキストマイニングの中心的な役割を果たしてきました。

アノテーションは人手を必要とする作業ですが、医学・生物学関係のテキストに対するアノテーションは、専門的な知識が必要で誰もができるわけではありません。そこで、多くのグループが文献アノテーションのデータセットを公開し、グループ間でアノテーション済みのテキストを共有しようとしています。

BLAHはそのような試みの一つで、同じテキストに対する複数のアノテーションの統合や、アノテーションに必要なツールや辞書などのデータ整備を共同で行うことを目標にしています。

BLAH6について

今年は「特別テーマ」としてソーシャルメディア(SNS)のマイニングがあげられました。

TwitterをはじめとしたSNSは人々の状況をタイムリーに反映するとされ、感染症の流行傾向や薬の副作用の出現傾向をさぐったり、筆者がうつ状態にあるかを判断し自殺などの防止に努める、などの研究が行われています。

研究目的に利用できるSNSのテキストは豊富にあるものの、文が短い、文体がととのっていない、ノイズが多い、省略や隠語のような特有の表現が見られる、など、新聞などの整った書き言葉を相手にしてきた従来の自然言語処理には難しいターゲットとなっていて、SNSテキストからの情報抽出は現在ホットな研究テーマとなっています。

今回のBLAHが行われたのは2月初めでしたが新型コロナウイルスの影響が出始めており、4名の海外参加者が直前でキャンセルになりました。それでも今回は国内外から51名の参加者があり、前回までの30名程度から大幅に増えました。

BioHackathonと同様、スケジュールの1日目はシンポジウム、2日目から最終日までは参加者がテーマごとにグループに分かれて、終日ハッカソンを行いました。最終日はラップアップとしてそれぞれのグループの進捗を発表しあいました。

シンポジウムは、当初JSTで行う予定でしたが、参加者が増えて会議室に入りきれなくなったため、急遽ルーテル市ヶ谷センターに場所を移して行いました。ハッカソンはJST東京本部2階の共創スペースで行いました。

シンポジウムの講演

シンポジウムでは、ハッカソン参加者からのプロジェクト紹介とともにキーノートスピーチと招待講演が2件ずつありました。

キーノートスピーチの一つ目はSNSマイニングにおける倫理を扱ったもので、研究発表やデータ公開の際にまもるべき、被験者個人情報に関連するガイドラインの話、二つ目は診療記録から種々のできごとの時系列を抽出する目的でのオントロジーベースの意味アノテーションの話でした。

招待講演ではスイスと日本での医療系のテキストマイニングの例が紹介されました。

スイスの方はチューリヒ大学での医学系自然言語処理研究を、今回の特別テーマであるSNSマイニングと、文献に出現するタンパク質名などに対するデータベースのIDアノテーションの話を中心に紹介されました。

SNSマイニングは、チューリヒ大学が製薬会社と共同で行っている、SNSの書き込みから薬の治験の被験者候補を見つけるプロジェクトで、疾患にかかっているかどうかの分類は深層学習を用いた分類器を使えばうまくいきそうとの見通しなのですが、むしろ、そもそも不要な書き込み、たとえば、広告や、「Parkinson」など疾患の名と同じ名前の人に対する書き込みを対象から外す処理が問題となっているとのことでした。

IDのアノテーションは、従来の「物の名前に相当する箇所を見つけてからデータベースを参照してIDを付与」と2段階に分けた処理をするよりも、両者をやはり深層学習を用いて一度に行ったほうがよいという結果と、それを利用した自動アノテーションのツール、さらに、複数のデータベースのIDをワンストップで検索するためのハブとなる辞書の紹介でした。

日本の方は静岡大の狩野先生のお話で、一つは慶応大学病院の精神科の患者さんの対話テキストから疾患ごとの特徴を見つける話、もう一つは浜松医科大学病院での発達障碍の診断からやはり会話の特徴から専門家の診断スコアとの関連を見つける話でした。

慶応大学病院での研究では、データが小さくてAIを使った機械的な診断ができるまでには至らなかったものの、各種の疾患に特徴的な会話の言語の傾向、たとえば、うつでは一人称代名詞が増える、統合失調症では「~に」という表現が減る、などがわかったそうです。浜松医科大学病院での研究では、やはりデータの数は少ないものの、自動診断でほぼ専門家に匹敵する精度が得られたそうです。

また、会話の書き起こしに人手が必要なこと、しかも、プライバシーの関係から信頼できる人にしか任せられないことや、患者さんの同意が得られても病院の同意が得られないので匿名化をした上でも書き起こしたデータの公開はできず、"研究として再現性がどうなの、といわれる"といった解きたい問題そのもの以外の苦労話もされていました。

シンポジウムの講演はTogoTVから公開されています。一部の講演については発表スライドをBLAH6のページからダウンロードできます。

オーガナイザーよりBLAHの全体紹介

ハッカソン

ハッカソンでは様々な方向性を持った15グループがグループ単位で、あるいは、グループ間で協力しながら開発を進めました。

特別テーマのSNS関係では、SNSマイニングのツールキットとそれを用いた中国語SNS(Weibo)データの作成、TwitterからNGLY1欠損症に関するツイートの抽出、のプロジェクトがありました。

私は「Human Phenotype OntologyとMammalian Phenotype Ontologyに共通の和訳を作る」プロジェクトに協力しつつ、「オープンな和英医学用語辞書にMeSH(Medical Subject Headings)のUIDを付与する」実験をしていました。

MeSHを付与する実験では、スペインのMedSpEnプロジェクトの多言語辞書と、アジア太平洋機械翻訳協会から公開されている北里大学の英和辞書、計 35,903の日本語見出しの英訳で2020年版のMeSHを検索するという単純な手法でMeSH IDを付与してみたところ、単純な一致では2,838語にしか付与できませんでしたが、大文字小文字、全角半角、ギリシャ文字と英語表記の揺れを解消した結果、最終的に1/3強にあたる12,457にMeSHのIDを付与することができました。また、他の和英辞書のエントリーにMeSH IDを付与するスクリプトも作成できました。

日本語の医学用語辞書は、ライフサイエンス辞書や医学中央雑誌の作成したものなど、Webベースで自由に検索できるものもありますが、プログラムから自由に利用できるものは奈良先端大の万病辞書など限られています。これはアメリカNLM(National Library of Medicine)のUMLS(Unified Medical Language Systems)のような大規模な辞書が公開されている英語とは違って、日本語の医療系テキストマイニングの発展の妨げの一つになっています。

我々の試みがこのような状況を改善する助けとなることを望んでいます。

各国から参加したメンバーが、集中して開発

終わりに

わからないことができると知っていそうな方に声をかけ、もしその方でもわからなければ別の方に声をかけていただき、こちらも何かできることがあればお手伝いするといった協力的な雰囲気の中で集中して取り組めた有意義な時間でした。

BLAHの各プロジェクトの成果はGenomics & Informatics誌の特集号として6月に公表される予定です。

Licensed under a Creative Commons 表示4.0国際 license

Licensed under a Creative Commons 表示4.0国際 license

©2020 建石 由佳(国立研究開発法人科学技術振興機構バイオサイエンスデータベースセンター)